Organized by the International Association for the Study of Pain (IASP) Special Interest Group on Neuropathic Pain, NeuPSIG brings together clinicians, researchers, and industry partners to exchange the latest scientific findings and explore new approaches to understanding and managing neuropathic pain.

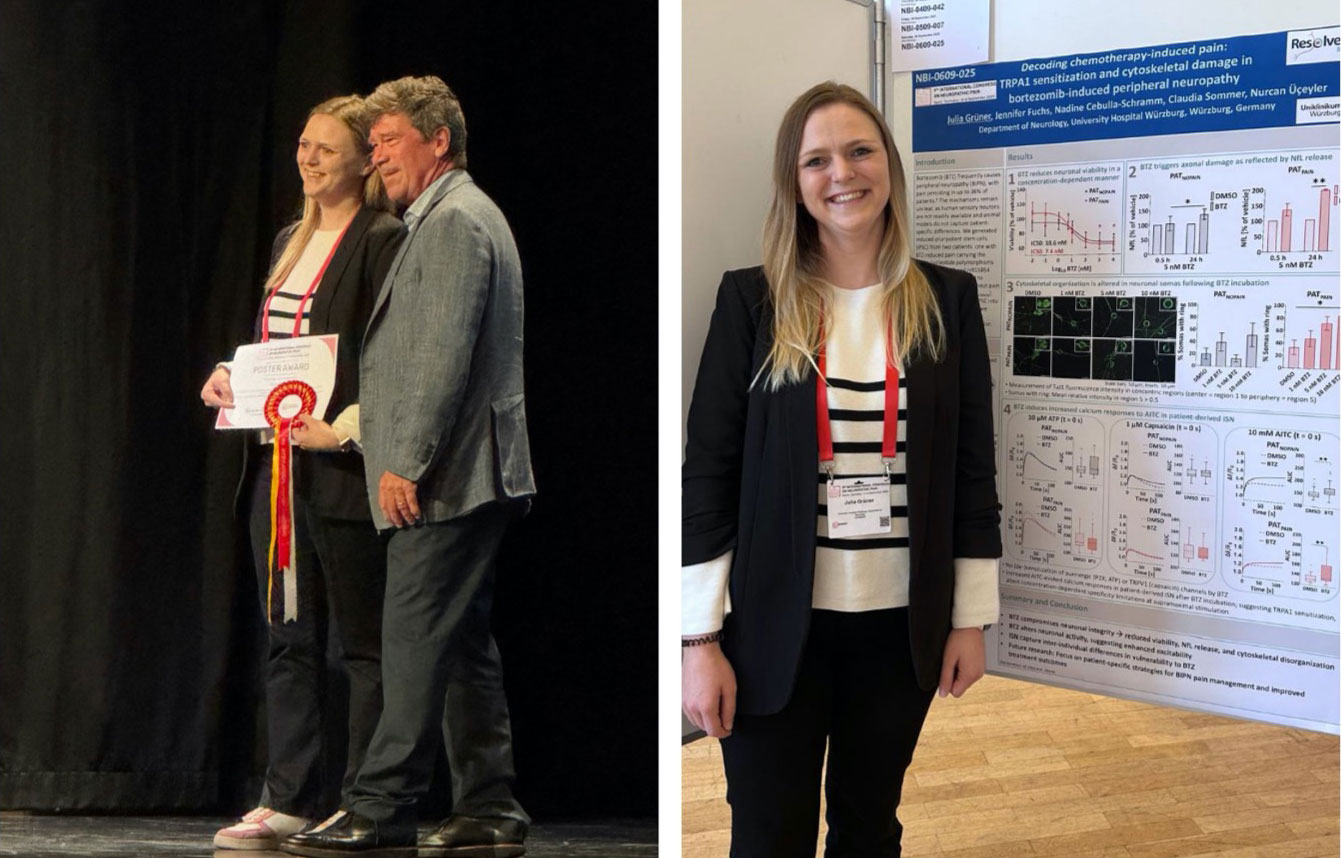

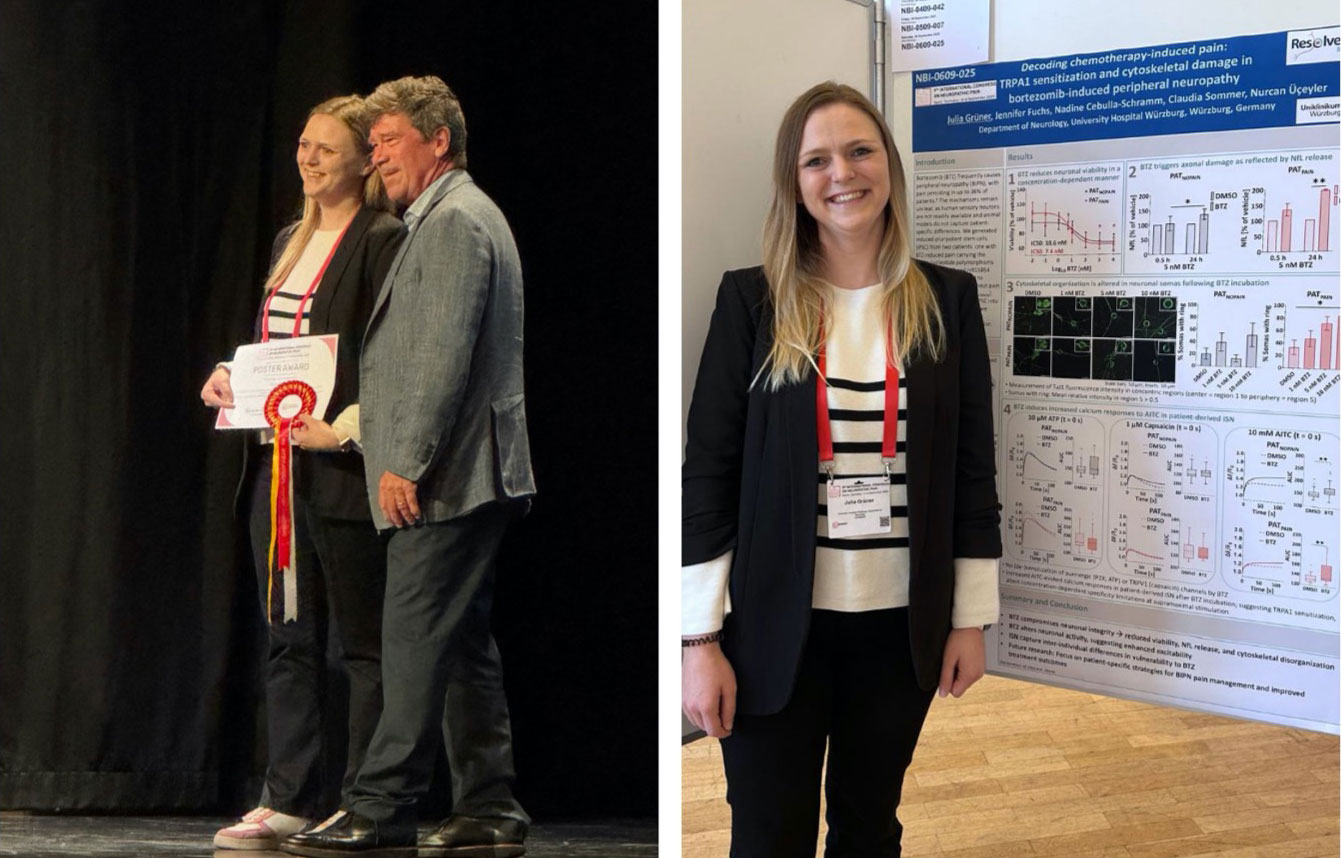

Members of KFO 5001 ResolvePAIN actively contributed to the congress with scientific presentations and discussions. Their work added valuable insights into the mechanisms of pain resolution and innovative strategies for translational research. We are especially proud that Dr. Julia Grüner (Postdoctoral Researcher, Project 2) was awarded a Poster Prize. This recognition highlights both the scientific quality of her project and the overall visibility of our research within the international pain community.

The congress also provided an important platform for networking and for strengthening collaborations within the international pain research community. KFO 5001’s presence at NeuPSIG 2025 highlights once again the group’s commitment to advancing knowledge in neuropathic pain and to fostering dialogue between basic science and clinical practice.